Autoavaliação de Impacto Ético da Inteligência Artificial no Setor Público (AIE)

Inicie a avaliação e obtenha uma visão clara sobre os potenciais impactos éticos, que ajudará a mitigar riscos e a construir uma solução de excelência. Recomendamos a leitura das informações nessa página antes de iniciar a autoavaliação.

Introdução e Contextualização

O que é

O Framework para Autoavaliação de Impacto Ético da Inteligência Artificial no Setor Público - AIE foi desenvolvido pelo Núcleo de IA como um instrumento consultivo para auxiliar os órgãos da administração pública federal brasileira na implementação e governança ética de soluções de IA. Em um cenário de rápida evolução tecnológica, onde a IA se torna cada vez mais presente nas operações governamentais, torna-se imprescindível estabelecer diretrizes que orientem seu uso responsável, transparente e centrado no cidadão.

Objetivo

Este framework possui caráter orientador, buscando promover uma cultura de responsabilidade ética no desenvolvimento e uso de sistemas de IA no setor público. Seu objetivo é fornecer um conjunto de princípios, recomendações e recursos que possam ser adaptados às realidades específicas de cada órgão, respeitando suas estruturas existentes e complementando iniciativas em andamento.

Contexto

Como versão beta, este framework representa o primeiro passo em direção a uma abordagem mais estruturada para a governança ética da IA no governo federal. Ele foi concebido para evoluir com base no feedback dos órgãos, nas lições aprendidas durante sua aplicação e nas mudanças no cenário regulatório e tecnológico.

Princípios Éticos Fundamentais para IA no Setor Público

Os seguintes princípios éticos devem nortear o desenvolvimento e a utilização de sistemas de IA no setor público brasileiro. O framework buscará verificar a aderência a estes princípios:

A IA deve respeitar os direitos humanos fundamentais, a dignidade das pessoas e promover a equidade, evitando a criação ou perpetuação de discriminações e desigualdades injustas.

Os sistemas de IA devem ser transparentes quanto aos seus propósitos e funcionamento. Suas decisões, especialmente as que podem ter alto impacto adverso a direitos fundamentais, precisam ser explicáveis e passíveis de auditoria, de modo a assegurar conformidade e avaliar seu desempenho.

Os sistemas de IA devem ser seguros, robustos contra falhas e ataques, e desenvolvidos sob o princípio da não maleficência, evitando a ocorrência de danos às pessoas e à sociedade.

O desenvolvimento e uso de IA devem garantir a privacidade e a proteção de dados, pessoais ou não, em todas as fases do ciclo de vida do projeto, respeitando a LGPD quando aplicável.

Deve haver supervisão humana significativa sobre os sistemas de IA, especialmente aqueles com potencial de alto impacto adverso a direitos fundamentais. Mecanismos de responsabilização devem permitir a atribuição de responsabilidades por decisões e resultados dos sistemas.

O desenvolvimento e a aplicação de IA devem considerar seus impactos socioambientais, buscando contribuir para o desenvolvimento sustentável e o bem-estar coletivo.

Quando e Como Aplicar o Framework

Este framework, juntamente com o questionário, deve ser utilizado como uma ferramenta de reflexão e análise crítica. Recomenda-se que seja aplicado de forma colaborativa, envolvendo, sempre que possível, equipes multidisciplinares que podem incluir:

O questionário é uma ferramenta dinâmica e iterativa, projetada para ser utilizada em diversas fases do ciclo de vida de um projeto de Inteligência Artificial. Para maximizar sua eficácia e garantir a proatividade na gestão de riscos éticos, é fundamental compreender o momento ideal e a forma de aplicação.

Momento de Aplicação

Recomenda-se que a Avaliação de Riscos seja aplicada nas fases iniciais de concepção e planejamento de qualquer projeto de IA. Identificar e avaliar os potenciais riscos éticos, legais e sociais desde o princípio permite:

Design Responsável: incorporar considerações éticas no design da solução, evitando problemas complexos e custosos de serem corrigidos em etapas posteriores.

Mitigação proativa: planejar e implementar medidas de mitigação de riscos antes que o desenvolvimento esteja avançado.

Alinhamento Estratégico: assegurar que o projeto esteja alinhado com os princípios éticos e normativos desde sua gênese.

Tomada de decisão informada: subsidiar a decisão de prosseguir ou não com o projeto, ou de ajustar seu escopo, com base em uma compreensão dos riscos.

Questionário Principal de Avaliação: (nas suas versões Simplificada, Padrão ou Completa, conforme o risco identificado na Avaliação de Riscos) deve ser preenchido e revisado ao longo do desenvolvimento e antes da implantação. Seus resultados devem informar continuamente o design, desenvolvimento, implementação e monitoramento do sistema de IA, promovendo um ciclo de melhoria contínua.

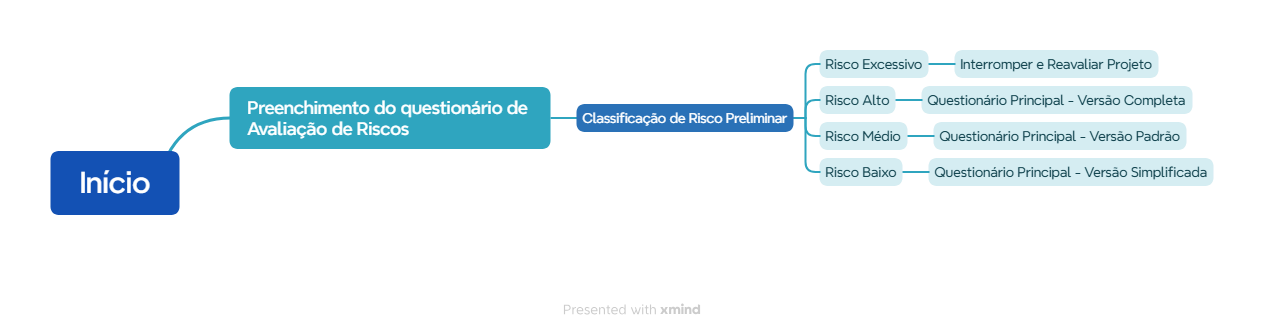

Fluxo de Aplicação no Ciclo de Vida do Projeto de IA

Orientações para casos de Risco Excessivo

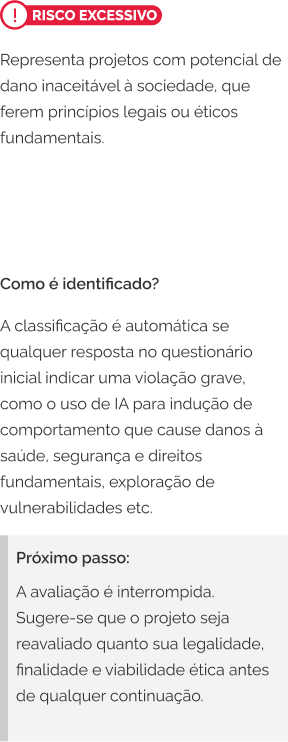

Quando a Avaliação de Riscos identificar Risco Excessivo, o projeto deve ser imediatamente reavaliado de forma aprofundada. O risco excessivo caracteriza-se por situações em que o sistema de IA pode causar danos irreversíveis, violar direitos fundamentais de forma sistemática ou operar fora do marco legal vigente.

São situações características de risco excessivo: Vigilância Biométrica; Decisões tomadas por IA de forma totalmente autônomas; Manipulação comportamental, etc.

Para os casos enquadrados como risco excessivo, é necessária uma revisão do projeto quanto à sua legalidade e viabilidade ética:

Estrutura da Avaliação de Impacto Ético em IA

A avaliação é composta por duas partes principais: Questionário de Avaliação de Riscos e Questionário Principal de Avaliação.

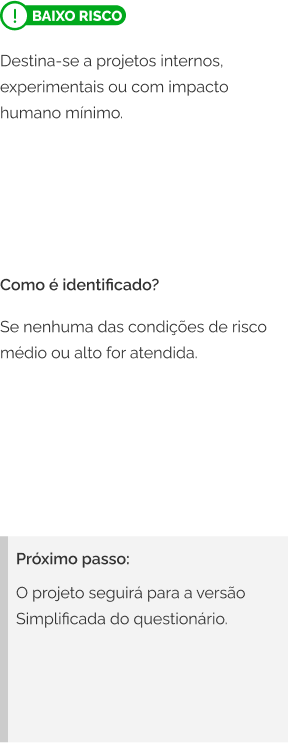

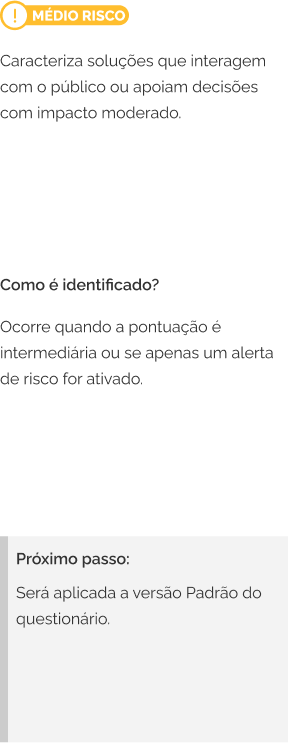

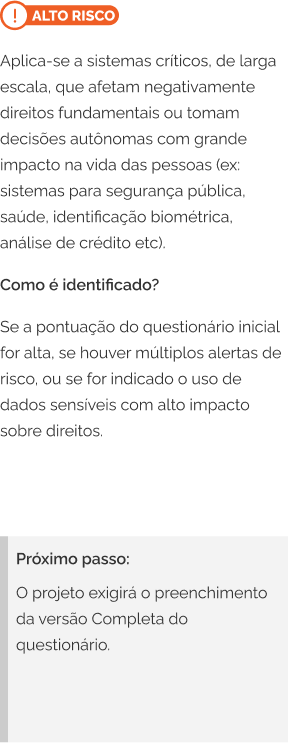

O Questionário de Avaliação de Riscos é composto por perguntas que visam avaliar o risco ético do projeto de Inteligência Artificial. Com base nas respostas fornecidas, o sistema classifica o projeto em um dos seguintes níveis de risco:

Essa classificação é importante porque define qual versão do Questionário Principal será aplicada a seguir ou, no caso de risco muito elevado, se o projeto deve ser interrompido para uma reavaliação mais profunda.

O Questionário Principal de Avaliação, por sua vez, é dividido em três versões distintas:

A versão a ser preenchida pelo órgão dependerá do resultado do Questionário de Avaliação de Riscos.

Questionário de Avaliação de Riscos

Pontuação

Cada pergunta da Avaliação de Riscos contribui com uma determinada pontuação para o projeto, calculada com base nos pontos por resposta e no peso da pergunta.

Gatilhos de Risco

Além da pontuação, algumas respostas contêm gatilhos, que são alertas automáticos sobre possíveis riscos:

O sistema contabiliza o número de gatilhos de alto risco ativados e verifica se algum gatilho crítico foi acionado.

Regras de Classificação

Após o preenchimento do questionário de Avaliação de Riscos, o seu projeto de IA será classificado em um dos quatro níveis de risco. A classificação determina os próximos passos e a complexidade da análise ética necessária:

Quadro Resumo

| Condição identificada na Avaliação de Riscos | Nível de risco | Versão do questionário principal | Observações |

|---|---|---|---|

| Qualquer resposta com gatilho: "EXCESSIVO" | Risco Excessivo | Nenhuma (avaliação interrompida) | Projeto deve ser reavaliado |

| Pontuação alta ou múltiplos gatilhos ativados | Risco Alto | Versão Completa | Análise Aprofundada é necessária |

| Pontuação média ou um gatilho ativado | Risco Médio | Versão Padrão | Requer atenção moderada |

| Nenhuma das condições anteriores | Risco Baixo | Versão Simplificada | Riscos éticos mínimos identificados |

Fluxograma Visual do Questionário de Avaliação de Riscos

Questionário Principal de Avaliação

O Questionário Principal analisa em profundidade os aspectos éticos e de governança do projeto de IA, conforme o nível de risco definido na Avaliação de Riscos. Ele busca identificar boas práticas e pontos críticos que precisam ser melhorados.

Pontuação

O sistema de pontuação calcula o quanto o projeto está aderente com os princípios éticos esperados. A pontuação é calculada da seguinte forma:

Sistema de Alertas

Embora um projeto possa ter alta aderência geral, pode haver também falha específica grave. Os Gatilhos Críticos servem para identificar esses pontos de atenção máxima.

1. Resposta de Risco Severo: Quando uma opção de resposta sinalizada como crítica é selecionada.

2. Admissão de Falha Essencial: Ao escolher uma resposta que admite a ausência de um requisito básico.

3. Baixo Desempenho em Seção-Chave: Ao obter menos de 50% de aproveitamento em uma seção do questionário marcada como crítica.

Quanto maior esse contador, mais severa pode ser a classificação final.

Classificação Final

Com base na pontuação e nos gatilhos críticos, o projeto pode ser classificado em 5 níveis:

Avaliação por Seção e Resultado

O relatório mostra o desempenho em cada seção do questionário. Algumas seções são marcadas como críticas, e baixo desempenho nelas aumenta o contador de gatilhos críticos e pode afetar a classificação final. Ao final da avaliação, a ferramenta gera um relatório consolidado que inclui:

- Nome do projeto

- Órgão

- Data da avaliação

- Nível de Risco Preliminar

- Respostas Fornecidas

- Versão do questionário utilizada

- Respostas para cada pergunta, incluindo justificativas

- Classificação Final: Nível alcançado (1 a 5)

- Detalhes da Pontuação: Score total e percentual de aderência

- Principais Fatores para a Classificação: Lista de razões (baseadas em respostas negativas, gatilhos críticos e desempenho em seções críticas)

- Recomendações para Melhoria e Avanço de Nível: Sugestões baseadas nas opções subótimas escolhidas

- Sugestões para Alcançar Práticas de Excelência: Recomendações baseadas nas melhores práticas descritas nas opções de maior pontuação

- Desempenho por Seção: Detalhamento da pontuação e percentual para cada seção, apresentado em lista e em gráfico de barras

- Orientações gerais com base na classificação final

O relatório pode ser baixado em formatos JSON, Texto (.txt) e Markdown (.md).

Comece sua avaliação agora mesmo!

Para garantir a melhor experiência, o questionário precisa ser baixado em sua máquina. É simples:

1. Baixe o arquivo .zip exclusivamente pelo nosso site oficial.

Atenção: não baixe este arquivo de terceiros ou links não oficiais.2. Extraia o arquivo.

3. Abra o arquivo .html com um duplo clique.

Pronto! O framework será carregado no seu navegador.

Recomendações, Orientações e Trilhas de Capacitação

As recomendações e orientações são baseadas nas respostas do questionário e visam auxiliar os órgãos a aprimorarem suas práticas em IA ética. Elas são apresentadas de forma consultiva e podem incluir sugestões de trilhas de capacitação, boas práticas e aprofundamento em temas específicos.

Trilhas de Capacitação e Recursos Adicionais

Esta seção apresenta trilhas de sugestões de materiais, frameworks e cursos organizados por nível de necessidade (básico, intermediário e avançado) em quatro esferas fundamentais para a implementação ética de sistemas de IA no setor público. As recomendações de quais trilhas utilizar aparecerão ao final do preenchimento do questionário principal.

Base Legal e Normativa

A versão Beta do Framework foi elaborada considerando o panorama normativo atual e em desenvolvimento no Brasil e internacionalmente, em especial as diretrizes do PL 2338/2023 (Apresentado em 03/05/2023), a Lei Geral de Proteção de Dados Pessoais (LGPD), as recomendações da UNESCO sobre Ética em IA e experiências internacionais como a Estratégia Pan-Canadense de IA e os preceitos da OCDE. As principais referências incluem:

Atualmente em discussão no Congresso Nacional, este projeto busca estabelecer os fundamentos e princípios para o desenvolvimento e uso da IA no Brasil. Embora ainda não aprovado, seus princípios e diretrizes foram considerados na elaboração deste framework, especialmente no que tange à classificação de sistemas e requisitos de transparência, explicabilidade e supervisão humana.

Estabelece regras sobre tratamento de dados pessoais, impondo diretrizes que afetam diretamente o desenvolvimento e uso de sistemas de IA que processam dados pessoais.

Instrumentos interconectados da UNESCO que estabelecem um referencial para a ética na Inteligência Artificial. As Recomendações de 2021 configuram o primeiro instrumento normativo global sobre o tema, adotado por 193 países, incluindo o Brasil, e estabelecem valores e princípios para orientar os Estados na formulação de legislações, políticas e outros instrumentos relativos à IA. O Ethical Impact Assessment, lançado em 2023 como uma ferramenta prática derivada dessas recomendações, visa auxiliar governos e desenvolvedores a avaliar riscos, benefícios e impactos éticos de sistemas de IA.

São instrumentos estratégicos e complementares que fundamentam e direcionam o desenvolvimento e a adoção da Inteligência Artificial no Brasil. A EBIA estabelece uma visão integrada e os princípios norteadores, com eixos que incluem legislação, regulação e o uso ético da IA. O PBIA, por sua vez, operacionaliza essa visão, além de estabelecer diretrizes de governança e regulação para a sua implementação prática.

Foram consideradas experiências e frameworks internacionais, como a Estratégia Pan-Canadense de IA, o Regulamento de IA da União Europeia (AI Act) e diretrizes da OCDE, bem como do IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems.

Documentos de Suporte

Em breve.

Canal Aberto para Colaboração

Por se tratar de uma versão beta, o framework está em constante aprimoramento. O MGI manterá um canal aberto para receber comentários e sugestões de órgãos públicos, gestores de projetos de IA, entidades governamentais e sociedade civil. Todas as contribuições serão acompanhadas por uma equipe dedicada, que avaliará continuamente as oportunidades de melhoria e promoverá o debate necessário para fortalecer a governança ética da inteligência artificial no setor público. As mensagens podem ser enviadas para o e-mail: ind.amplia@gestao.gov.br